🎲 "운이 전부라고? 정말 그럴까?"

매주 토요일, 누군가는 인생이 바뀝니다.

TV 앞에서 로또 추첨을 보며 이런 생각 해보신 적 있나요?

"어떻게 저 번호를 맞췄지? 그냥 운일까?"

물론 운이 큰 역할을 하긴 합니다.

하지만 1,000회를 훌쩍 넘긴 로또 추첨 데이터를 떠올려보면, 이야기가 조금 달라집니다.

이 많은 데이터 속에,

우리가 놓친 작은 패턴이 숨어있을 수도 있지 않을까요?

🧠 "AI는 왜 데이터를 필요로 할까?"

AI가 똑똑해지는 데 가장 중요한 건 뭘까요?

천재적인 알고리즘? 슈퍼컴퓨터?

정답은 바로 데이터입니다.

AI는 인간처럼 직감이나 육감을 갖고 있지 않아요.

대신 수많은 데이터를 분석해서 그 안에서 규칙을 찾아내고, 학습합니다.

이걸 우리는 흔히 빅데이터(Big Data) 라고 부르죠.

하지만, 데이터를 아무리 많이 줘도

AI가 한 번에 전부 처리할 수는 없습니다.

그래서 데이터를 작은 청크(Chunk) 로 나누고,

그걸 모아서 데이터셋(Dataset) 을 만든 뒤,

거기서 특징(Feature) 을 추출해 학습하는 방식으로 진행됩니다.

🎯 로또 번호 예측 AI는 이렇게 시작됩니다

로또 예측 AI도 마찬가지입니다.

과거의 수많은 당첨 번호 데이터를 모으면, AI는 그 안에서 패턴을 찾아 다음 당첨 번호에 대한 예측 모델을 만들 수 있습니다.

📊 빅데이터의 핵심 요소: 3V

빅데이터는 단순히 '많은 데이터'를 뜻하지 않습니다.

아래 3가지 특징을 만족해야 합니다:

1️⃣ Volume (규모)

: 방대한 양의 데이터. 예) 수백만 건의 로또 번호 기록

2️⃣ Variety (다양성)

: 텍스트, 숫자, 이미지 등 다양한 형태의 데이터

3️⃣ Velocity (속도)

: 데이터가 빠르게 생성되고, 빠르게 처리되어야 함

로또 데이터를 AI가 다룰 수 있게 만들려면

이 3V 특성을 잘 활용해야 합니다.

🗂️ "어떤 데이터를 모아야 할까?"

로또 예측 AI를 위해 필요한 데이터는 아래와 같습니다:

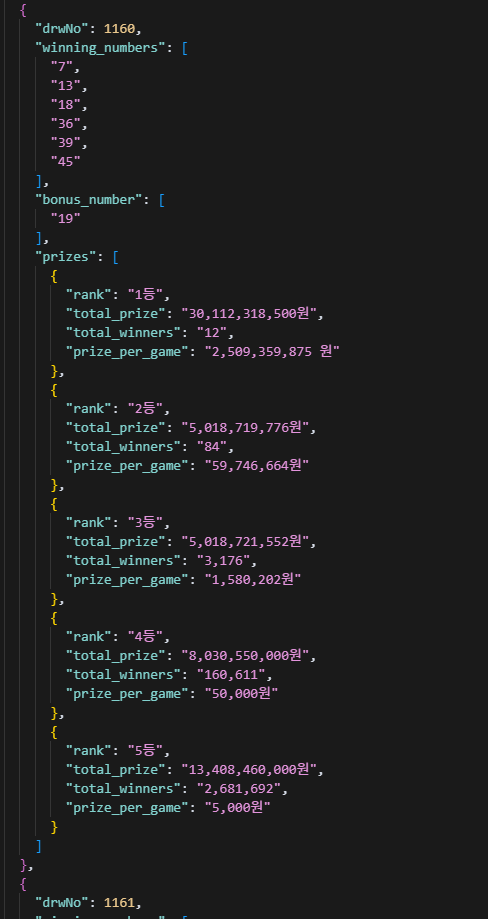

- 회차 번호 (ex. 1회, 2회, ... 1xxx회)

- 당첨 번호 6개

- 추첨일자 (ex. 2025년 4월 26일)

- ❌ 보너스 번호는 이번 프로젝트에선 사용하지 않습니다

✔️ 중요한 포인트:

데이터는 항상 일관된 형식으로 정리되어야

AI가 올바르게 이해하고 학습할 수 있어요.

🛠️ "데이터는 어디서 구할 수 있을까?"

다행히도, 로또 당첨 데이터는 공식 사이트나 공개 API, 또는 웹 크롤링을 통해 수집할 수 있습니다.

데이터 수집 흐름 예시:

- 로또 공식 사이트 접속

- 당첨 번호 모음 페이지 방문

- 크롤러나 스크립트로 긁어오기

- CSV 파일로 정리 → AI가 읽을 수 있게 저장

이렇게 하면 AI의 학습을 위한 출발선이 완성됩니다.

"1169회 로또 5게임 구매했는데 모두 합쳐서 2개 맞았네요 ㅠㅠ"

⚖️ "크롤링, 합법일까?"

크롤링은 '무조건 불법'도 아니고 '완전히 합법'도 아닙니다.

다만, 법적 문제를 피하기 위해 아래 내용을 꼭 확인하세요:

1️⃣ robots.txt 확인

: 크롤링 허용 여부를 사이트가 명시한 파일입니다. 없다고 무조건 허용은 아닙니다.

2️⃣ 저작권/부정경쟁방지법

: 데이터 자체는 보호받지 않지만, 데이터베이스 구조는 보호될 수 있어요. 특히 상업적 이용 시 주의.

3️⃣ 사이트 이용약관

: 무단 수집, 복제, 배포를 금지한다면 법적 책임이 따를 수 있습니다.

✔️ 항상 합법적인 방법으로 데이터를 수집하세요.

크롤링 자체는 '불법이다, 합법이다'라는 명시적인 규정은 없습니다.

다만, 타인의 권리를 침해할 경우 법적 문제가 발생합니다.

대상 사이트를 크롤링 하기전에 꼭! 다음 사항을 확인하세요.

1️⃣ 크롤링 허용 여부: 사이트에 robots.txt 파일을 열어 "User-agent"와 "Disallow" 지침을 확인.

만약 파일 자체가 없다면 크롤링에 대한 명시적 제한이 없습니다. 그러나 이는 기술적인 제한이 없다는 뜻일 뿐, 법적 허용 여부는 별개입니다.

2️⃣ 저작권 및 부정경쟁방지법: 단순한 데이터는 일반적으로 저작권 보호를 받지 않지만, 사이트가 구축한 데이터베이스는 보호될 수 있습니다. 상업적 이용이나 반복 크롤링은 법적 문제가 될 수 있습니다.

3️⃣ 이용약관: 사이트 약관에서 무단 복제, 배포, 상업적 이용을 금지하고 있는 경우 이를 위반하면 법적 책임이 따를 수 있습니다.

AI가 이해할 수 있는 디지털 형태로 수집 완료.

✨ "데이터 속에 숨어 있는 비밀, AI가 찾을 수 있을까?"

아직 우리는 모릅니다.

진짜 패턴이 숨어 있을지, 아니면 완전한 랜덤일지.

하지만 한 가지는 분명합니다:

"데이터가 준비되어 있어야, 탐험을 시작할 수 있다."

📚 용어 설명

- 청크(Chunk): 큰 데이터를 작은 조각으로 나누어 처리하는 단위.

- 데이터셋(Dataset): AI가 학습할 수 있도록 정리된 데이터 집합.

- 특징(Feature): 데이터에서 중요한 정보를 추출하여 모델이 학습할 수 있는 형태로 변환한 값.

- 빅데이터(Big Data): 전통적인 데이터 처리 방식으로는 다루기 힘든 방대한 양의 데이터.

- robot.txt: 웹사이트의 크롤링을 관리하기 위한 파일, 크롤링 허용 여부를 확인할 수 있습니다.

🚀 이제 데이터를 수집했다면, 다음 단계는 AI가 이해할 수 있도록 가공(전처리) 하는 과정입니다.

이처럼 데이터는 단순히 모으는 것보다, 정제와 구조화가 더 중요합니다.

이후 단계에서는 이 데이터를 기반으로 AI가 어떻게 패턴을 인식하고 예측하는지 확인해볼 수 있습니다.